이 글의 원문은 https://opencv-python-tutroals.readthedocs.io/en/latest/py_tutorials/py_imgproc/py_pyramids/py_pyramids.html#pyramids 입니다.

동일한 영상에 대해서 이미지의 크기를 50% 크기만큼 연속적으로 줄이거나 늘려 생성된 이미지 집합을 이미지 피라미드라고 합니다. OpenCV에서 제공하는 이미지 피라미드 관련 함수는 cv2.pyrDown과 cv2.pryUp 인데, cv2.pyrDown 함수는 입력 이미지를 50% 크기로 줄인 이미지를 생성해 반환하고 cv2.pryUp은 입력 이미지를 200% 크기로 확대한 이미지를 생성해 반환합니다. 먼저 cv2.pryDown 함수의 예를 살펴보면..

import cv2

img0 = cv2.imread('./data/apple.jpg')

img1 = cv2.pyrDown(img0)

img2 = cv2.pyrDown(img1)

img3 = cv2.pyrDown(img2)

cv2.imwrite('img0.jpg', img0)

cv2.imwrite('img1.jpg', img1)

cv2.imwrite('img2.jpg', img2)

cv2.imwrite('img3.jpg', img3)

위의 예제에서 apple.jpg 이미지는 512×512 크기의 이미지인데, img1은 256×256으로.. img2는 128×128으로.. img3는 64×64로 크기가 축소된 이미지가 저장됩니다. 다음은 cv2.pryUp 함수에 대한 예제입니다.

import cv2

img0 = cv2.imread('./data/apple.jpg')

img1 = cv2.pyrUp(img0)

img2 = cv2.pyrUp(img1)

img3 = cv2.pyrUp(img2)

cv2.imwrite('img0.jpg', img0)

cv2.imwrite('img1.jpg', img1)

cv2.imwrite('img2.jpg', img2)

cv2.imwrite('img3.jpg', img3)

위의 예제 역시 유사하게 apple.jpg 이미지는 512×512이고, img1.jpg는 1024×1024로.. img2는 2048×2048로.. img3는 4096×4096의 크기로 확대되어 저장됩니다.

지금까지의 이미지 피라미드는 Gaussian Pyramid 라고 하는데, Laplacian Pyramids 라는 종류의 피라미드가 있습니다. Laplacian Pyramids는 Gaussian Pyramid로부터 생성되며 OpenCV에서 이를 위해 별도로 제공하는 함수는 없습니다. Gaussian Pyramid는 Gaussian Pyramid로부터 생성된 이미지들에 대한 외곽선 추출 이미지들의 집합입니다.

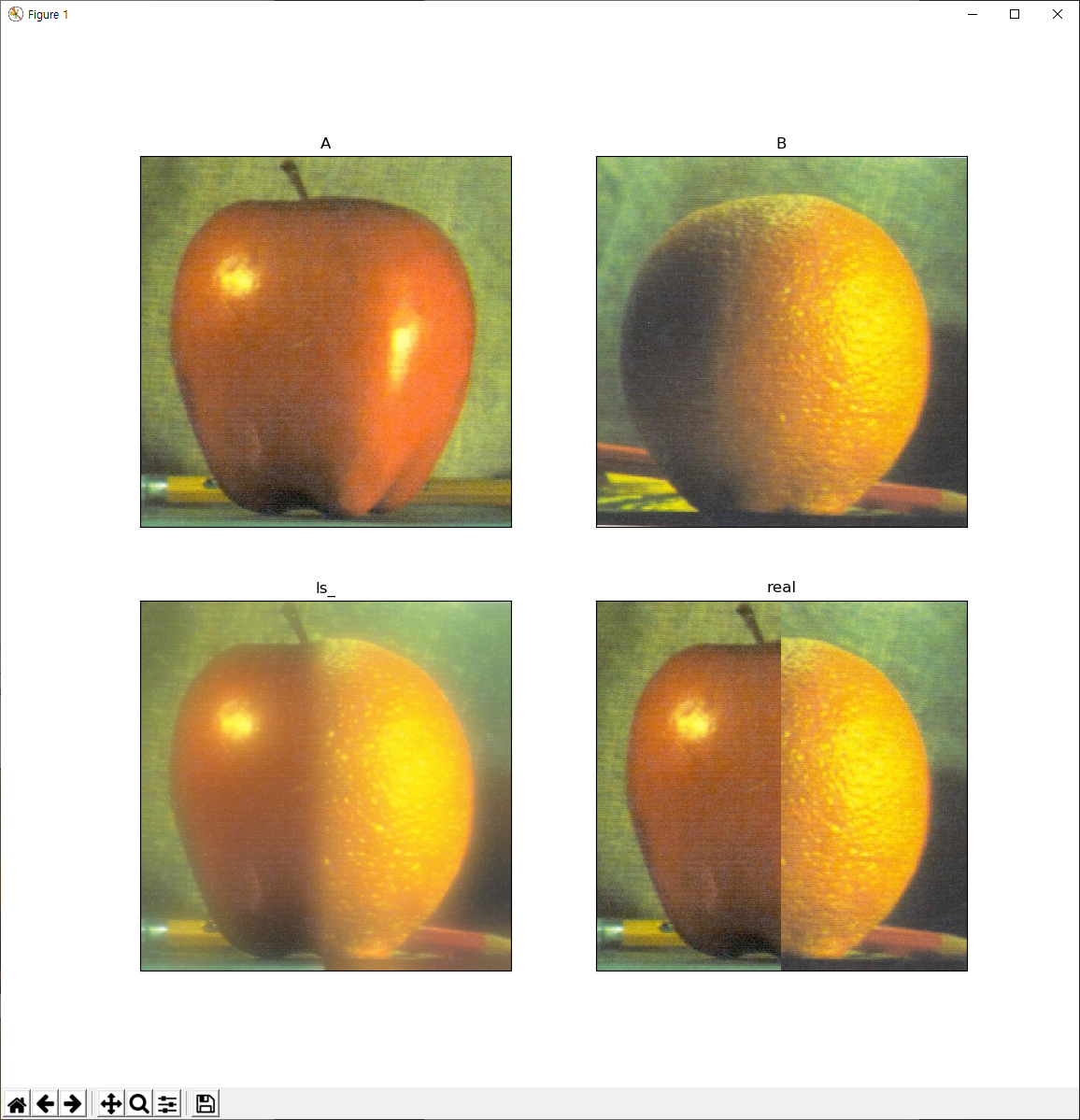

이미지 피라미드에 대한 응용 중 하나로 Image Blending이 있습니다. 하나의 예제 코드를 언급할텐데, 그 예제 코드의 결과를 먼저 보면..

A 영상과 B 영상의 반씩 혼합하여 ls_과 real이라는 새로운 영상을 만드는 것인데 real은 단순히 A와 B 각각 좌우에 대한 이미지를 붙인 이미지이지만 ls_는 A와 B를 붙인 경계가 날카롭지 않고 자연스럽습니다. 이런 ls_를 생성하는 절차는 다음과 같습니다.

- A와 B 이미지를 로딩한다.

- A와 B에 대한 Gaussian Pyramid를 생성한다. (6개 정도)

- Gaussian Pyramid로 생성된 결과로부터 Laplacian Pyramids를 생성한다.

- Laplacian Pyramids의 각 레벨에 대한 A와 B 영상의 반절씩 조합한다.

- 앞서 조합한 이미지 피라미드로부터 원본 이미지를 다시 생성한다.

위의 절차에 대한 코드는 다음과 같습니다.

import cv2

import numpy as np

from matplotlib import pyplot as plt

A = cv2.imread('./data/apple.jpg')

B = cv2.imread('./data/orange.jpg')

# generate Gaussian pyramid for A

G = A.copy()

gpA = [G]

for i in range(6):

G = cv2.pyrDown(G)

gpA.append(G)

# generate Gaussian pyramid for B

G = B.copy()

gpB = [G]

for i in range(6):

G = cv2.pyrDown(G)

gpB.append(G)

# generate Laplacian Pyramid for A

lpA = [gpA[5]]

for i in range(5,0,-1):

GE = cv2.pyrUp(gpA[i])

L = cv2.subtract(gpA[i-1],GE)

lpA.append(L)

# generate Laplacian Pyramid for B

lpB = [gpB[5]]

for i in range(5,0,-1):

GE = cv2.pyrUp(gpB[i])

L = cv2.subtract(gpB[i-1],GE)

lpB.append(L)

# Now add left and right halves of images in each level

LS = []

xxx = 0

for la,lb in zip(lpA,lpB):

rows,cols,dpt = la.shape

ls = np.hstack((la[:,0:int(cols/2)], lb[:,int(cols/2):]))

LS.append(ls)

# now reconstruct

ls_ = LS[0]

for i in range(1,6):

ls_ = cv2.pyrUp(ls_)

ls_ = cv2.add(ls_, LS[i])

# image with direct connecting each half

real = np.hstack((A[:,:int(cols/2)],B[:,int(cols/2):]))

b, g, r = cv2.split(A)

A = cv2.merge([r,g,b])

plt.subplot(2,2,1), plt.imshow(A), plt.title('A'), plt.xticks([]), plt.yticks([])

b, g, r = cv2.split(B)

B = cv2.merge([r,g,b])

plt.subplot(2,2,2), plt.imshow(B), plt.title('B'), plt.xticks([]), plt.yticks([])

b, g, r = cv2.split(ls_)

ls_ = cv2.merge([r,g,b])

plt.subplot(2,2,3), plt.imshow(ls_), plt.title('ls_'), plt.xticks([]), plt.yticks([])

b, g, r = cv2.split(real)

real = cv2.merge([r,g,b])

plt.subplot(2,2,4), plt.imshow(real), plt.title('real'), plt.xticks([]), plt.yticks([])

plt.show()