Xr 솔루션의 구성 제품 중 Web GIS 솔루션인 GeoService-Xr과 FingerEyes-Xr에 대한 제안을 위해 작성한 자료입니다. 올해의 끝 마무리에 마지막으로 제안한 것으로 좋은 결과가 나왔으면 참… 좋겠습니다..

공간정보시스템 / 3차원 시각화 / 딥러닝 기반 기술 연구소 @지오서비스(GEOSERVICE)

Xr 솔루션의 구성 제품 중 Web GIS 솔루션인 GeoService-Xr과 FingerEyes-Xr에 대한 제안을 위해 작성한 자료입니다. 올해의 끝 마무리에 마지막으로 제안한 것으로 좋은 결과가 나왔으면 참… 좋겠습니다..

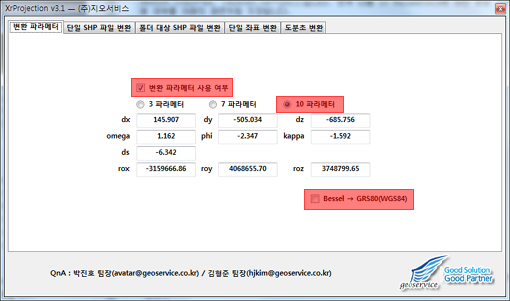

XrProjection을 이용하여 10 Parameters가 적용된 UTM-K(GRS80 타원체)를 카텍(Bessel 타원체) 좌표계로 변환하는 과정을 정리해 보겠습니다. 변환할 좌표는 UTM-K(GRS80 타원체) 좌표값인 (965828.10423749, 1929063.04772911)입니다. 먼저 다음 10 Parameters에 대한 변환 파라메터 사용 여부를 아래의 화면처럼 지정합니다.

위의 화면을 설명하면, 먼저 변환 파라메터 사용 여부를 체크하고 10 파라메터를 선택합니다. 그리고 Bessel→GRS80(WGS84)가 체크 되지 않도록 합니다. Bessel→GRS80(WGS84)를 체크하지 않은 이유는 변환할 좌표계가 GRS80 타원체이고 변환되어질 결과 좌표가 Bessel 타원체이기 때문입니다.

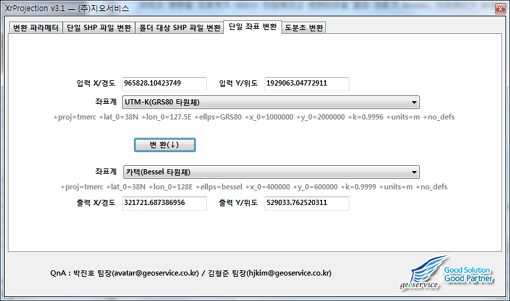

다음으로 변환할 좌표값을 입력하기 위해 아래의 화면처럼 필요한 내용을 입력합니다.

먼저 변환할 UTM-K(GRS80 타원체) 좌표값인 (965828.10423749, 1929063.04772911)을 입력하고 이 좌표계가 무엇인지 선택합니다. 즉, UTM-K(GRS80 타원체)입니다. 그리고 변환 되어질 좌표계를 선택하는데, 카텍(Beessel 타원체)를 선택합니다. 그리고 변환 버튼을 클릭하면 변환된 좌표가 표시됩니다.